Für Langzeit-Leser dieses Blogs muss es ein wunderbarer Running Gag sein: Jedes Semester aufs Neue kommen wieder Studenten, die ihre erste Studioproduktion durchführen und denken, sie seien die Herren der Schöpfung. Sie schmieden einen Plan aus Träumen im Feuer der wirren Fantasien und sind bis zu einem gewissen Punkt fest davon überzeugt, dass sie alles davon umsetzen können. Funktional, im Zeitrahmen und dazu noch ansehnlich.

An diesem gewissen Punkt sind wir gerade. Und er ist ernüchternd.

Wir von der Mediensteuerung träumten, wie viele Narren vor uns, wir könnten alles automatisieren, alles miteinander verbinden was nur im Entferntesten verbunden werden kann und das ganze noch in der kurzen Zeit eines Sommersemesters unter eine bahnbrechende Benutzeroberfläche stecken, sodass man das Ergebnis für tausende von Euro hätte verkaufen können. An Kunden mit sehr speziellen Bedürfnissen.

Wir sind alle nicht gut in Informatik. Ich habe gelernt, einen grünen Knopf auf den Bildschirm zu programmieren, der einen beleidigt, wenn man ihn drückt. Nun arbeiten wir mit Sprachen und Programmen, die nichts mit grünen Knöpfen zu tun haben. Ja, V4 hat man uns mal gezeigt und ja, von Unity haben wir auch schon gehört. Und was, jetzt haben wir 5 Wochen um die eierlegende Wollmilchsau zu programmieren?

„Fake it ‘till you make it“ – man ist ja selbstbewusst.

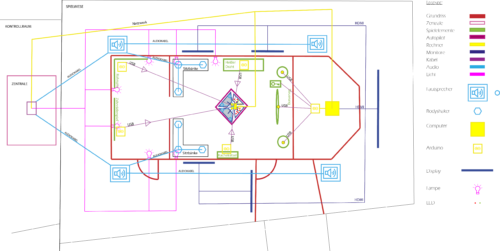

Der Plan sah wie folgt aus: Die Startsequenz bis zum Beginn der Interaktion der Besucher ist ein audiovisuelles Erlebnis. Surround Sound, Body Shaker, das Abheben in einer 3D-Welt über LED-Panels. All das wird vollautomatisch abgespielt. Soweit sind wir noch dabei. Dann aber kommt die Interaktion. Unterschiedlichste Rätsel müssen gelöst werden, dafür geben alle Arten von Sensoren ein kontinuierliches Feedback an einen Überwachungs-PC im Nebenraum. Man muss zu jeder Zeit wissen, wie weit die Besucher sind. Sollten sie aus dem Zeitrahmen fallen, muss das Spiel von außen manipulierbar sein. Gibt der entsprechende Sensor grünes Licht, soll heißen das Rätsel wurde gelöst, wird an einer anderen Stelle im Raum ein Sound abgespielt, LEDs schalten um und Anzeigen gehen in den „grünen Bereich“. Sind alle Rätsel gelöst und der Schlüssel eingesteckt, wird die manuelle Steuerung aktiviert. Wieder drei Sensoren geben ein konstantes Signal an die Rechnereinheit: Flugsimulation 3D Welt. Auch hier: unterschiedlichste Szenarien, die Eintreten können. Wir wollen immer den Überblick haben, was gerade passiert. Kameras überwachen das ganze Geschehen.

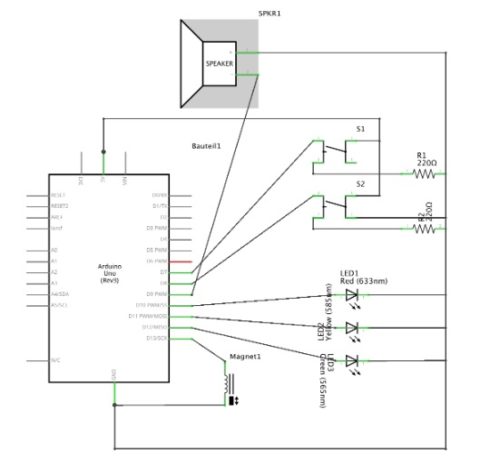

Alles zusammen: 3 Rechnereinheiten, einer davon mit V4, der Andere mit Unity und der Dritte mit einer HTML Oberfläche zur Überwachung. Dazu ein halbes Dutzend Arduinos, doppelt so viele Sensoreinheiten und dreimal so viele LEDs in unterschiedlichen Farben. Zu guter Letzt: 4.5 Soundsystem. Ja, richtig gelesen, 4.5. Wir stehen auf Bass. Weiter Lautsprecher im Autopiloten sowie an der Steuereinheit. Licht kommt hauptsächlich von 4 Monitoren und einem gigantischen LED-Panel.

Der Code auf den Arduinos selbst lässt sich zu 90% aus Tutorials copypasten. Das soll nicht das Problem sein. Das Problem ist die Automatisierung. Autarke Spiele, die den Mensch als Kontrolleur überflüssig machen. Im Idealfall führen diese nach einem Spiel sogar einen Auto-Reset durch. Von diesem Traum müssen wir weg.

Aufgrund der Zeit und unserer fehlenden Sicherheit in den Programmen wurden unsere Träume angepasst. Funktioniere! Wenn wir es schaffen, die richtigen Signale zum richtigen Zeitpunkt an den richtigen Ort zu schicken und damit eine LED angeht sind wir vorerst zufrieden.

Wer jetzt glaubt, dass das unser finaler Anspruch ist kennt uns falsch. Zufrieden sind wir, weil das Spiel an der MediaNight auf jeden Fall stabil funktioniert. Sollten wir es aber schaffen, früher damit fertig zu werden und unsere neuen Träume 2.0 zu verwirklichen dann kommt die Automatisierung und die Benutzeroberfläche.

Auch wenn die Besucher davon nichts mitbekommen. Einfach nur um uns zu beweisen: Ja, wir sind wirklich die Herren der Schöpfung. Warum sonst programmieren wir.

Beitrag von Florin Schwarz